AI VS 人類工程師的競技:程式編寫技能的比較

根據 codesignal 報道,在科技迅速發展的今天,人工智慧(AI)在各行各業的應用越來越廣泛,尤其是在招聘領域。今天,《AI 基準報告》對多種流行的 AI 模型進行了比較,特別是在程式編寫技能方面。隨著 OpenAI 最新模型的推出,現在正是分享發現的好時機。

報告方法

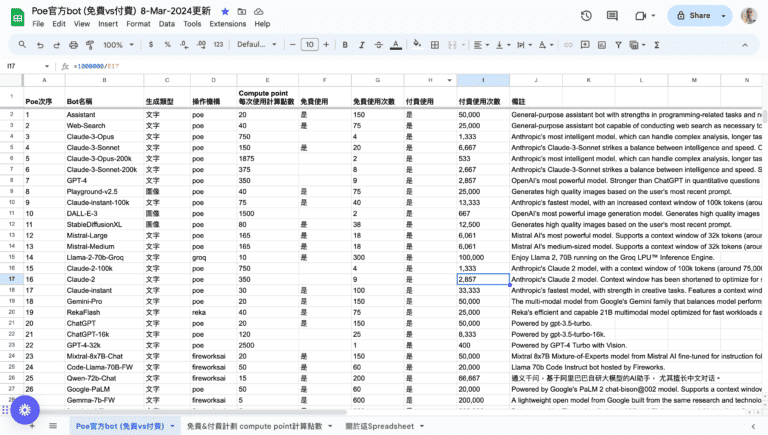

為了撰寫這份報告,幾個最先進的大型語言模型(LLMs)進行了測試,使用了 159 種框架評估變體,這些評估是客戶,包括多家大型科技和金融公司的標準。這些問題不僅測試一般的程式編寫能力,還針對邊緣情境進行考察,提供了實用的見解來幫助設計 AI 協助的評估。

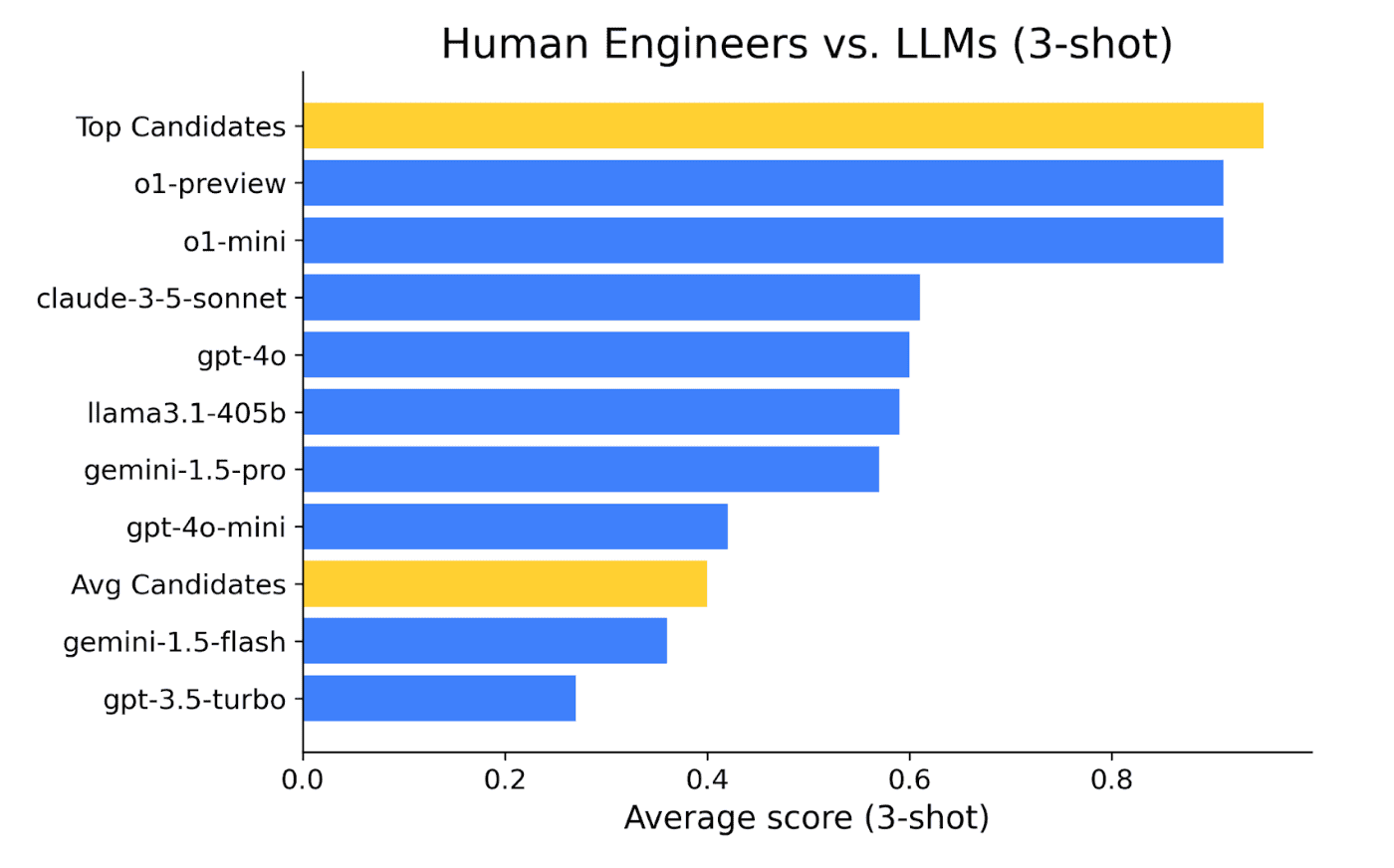

AI 模型評估基於兩個關鍵性能指標:平均分數和解題率。這些指標的範圍從 0 到 1,數值越高代表編碼表現越佳。

人類對照組

基準與超過 500,000 次計時測試的 robust human dataset 進行比較,並考察了相同問題庫中人類的平均分數和解題率。特別關注了得分在前 20% 的“頂尖候選人”與一般候選人的差異。

AI 模型排名

基準測試揭示了 AI 模型表現的幾個有趣見解。o1-preview 和 o1-mini 模型在各項指標中表現突出,成為表現最優異的模型。然而,其他模型在分數和解題率上存在有趣的差異。例如,GPT-4o 在處理所有邊緣情境時表現尤為出色,而 Sonnet 在簡單編程問題上則略勝一籌。雖然 Sonnet 在解決簡單任務時表現穩定,但在處理更複雜的問題時,GPT-4o 卻能更有效地應對。

在報告中,”multi-shot” 指的是模型在獲得反饋後,能夠對其代碼的表現進行改進,這與人類在收到反饋後經常會透過迭代來優化解決方案的過程相似。接下來,比較 AI 的 3-shot 分數與人類候選人的表現,後者在計時測試中可以進行多次嘗試。

人類表現 vs. AI

儘管大多數 AI 模型的表現超過了普通的預篩選軟體工程應徵者,但頂尖候選人的表現仍然優於所有 AI 模型。在一些問題上,即使是表現最好的 o1-preview 模型,也無法完全解決 25% 的人類候選人能成功解決的問題。這顯示出,儘管 AI 模型在某些編碼任務中表現出色,人類的直覺、創造力和適應能力在處理更複雜或不可預測的問題時仍具優勢。

這一發現強調了人類專業知識在 AI 可能面臨挑戰的領域中的重要性,並強化了未來軟體開發和創新需要人類和 AI 緊密合作的觀點。

未來:AI 與人類在評估中的合作

基準結果顯示,儘管像 o1-preview 這樣的 AI 模型越來越強大,但人類工程師在解決 AI 難以複製的獨特問題上仍然表現優異。人類的直覺和創造力在解決複雜或邊緣情境問題方面尤為重要。這表明,結合人類和 AI 的能力可以在應對困難的工程挑戰時取得更大的成就。

為了幫助公司把握這一潛力,CodeSignal 提供了 AI 協助編碼框架,旨在評估候選人如何將 AI 作為合作夥伴。這一框架包括一些 AI 無法完全解決的問題,確保人類的參與仍然至關重要。通過將 AI 助手 Cosmo 直接嵌入評估環境,候選人可以利用 AI 工具展示他們如何與 AI 協作,為未來的工程挑戰做好準備。

結論

希望 CodeSignal 的新 AI 基準報告能幫助企業在開發工作流中整合 AI。該報告展示了 AI 模型之間及與真實工程候選人的比較,提供了可操作的數據,幫助企業設計更有效的 AI 驅動工程團隊。

AI 協助編碼框架(AIACF)進一步支持了這一過渡,幫助公司評估候選人與 AI 合作的能力,確保所聘請的工程師不僅具備技術能力,還能熟練利用 AI 作為合作夥伴。這些工具共同提供了一種全面的方法,來構建未來的軟體工程——在這裡,人類的創造力與 AI 的能力相結合,推動創新。