ChatGPT 記性有幾強?為何最近常常沒有 Chat 的紀錄?

我終於研究到 Long Short Term Memory (LSTM)的意思,就字面意思的話是又長又短的記憶,然而經過一輪搜集資料我終於知道應用在 AI 工具的 LSTM 是什麽概念

Long Short Term Memory (LSTM)

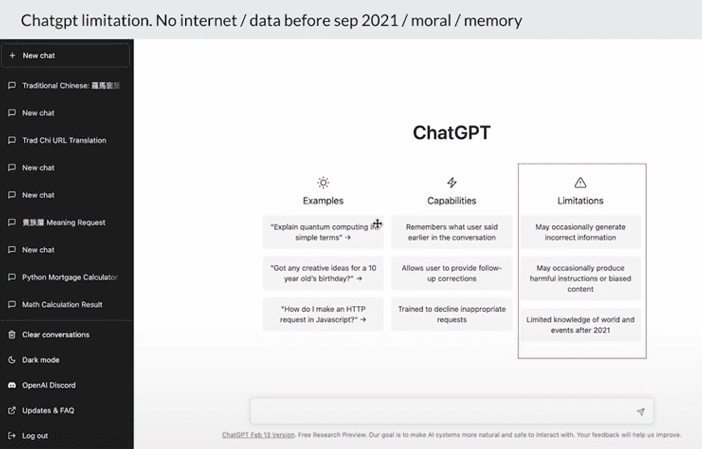

我們現在用的 Chat GPT 有幾個屬性,除了 Limitation 之外,就是它能夠記住和我們溝通的前言所以它會記錄下來

當我們問問題的時候它會根據我們溝通過的東西可以繼續回答下去,就好像有記憶力

這個記憶力的 Memory 其實我們就叫做 Short 就是一個 Memory;但它的叫法就叫做LSTM 就是一個 Long Short Term Memory

就是一個很短暫的記憶;但又有一個很長很短的記憶的意思(一開始我看了一下是什麼不太明白)

然後我在 Wiki 看完解釋之後(看完之後更加不明白),然後我就嘗試去研究

後來我發現了一個簡單的講法去解釋 LSTM

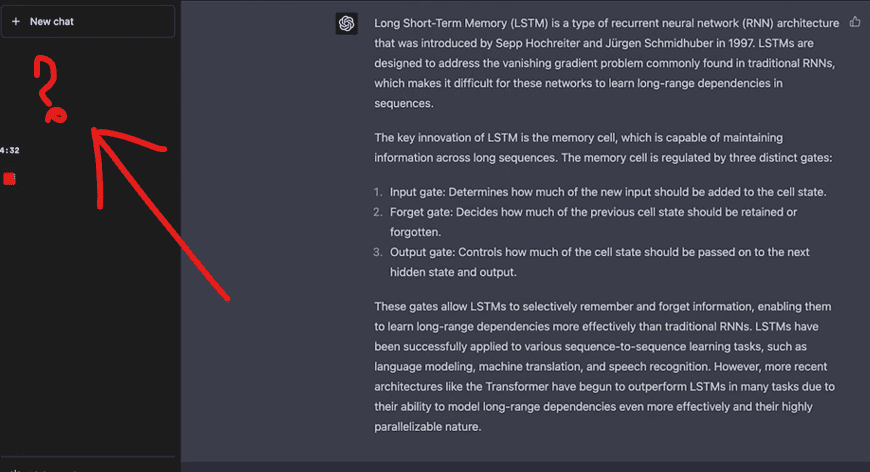

就是 AI 工具或者是 Chat GPT 它為什麼會記得和我們溝通的東西、還有就是現在我用Chat GPT

你看到左手邊的位置,它沒有了那些檢查的歷史就是有時候會有問題,可能這個原因會導致問題產生

我講一講給大家聽我的看法,我們平時在 Chat GPT 那裡打東西,一直在輸入資訊的時候其實就是屬於一個輸入一個閘口

如果當水喉就是我們一直輸入很多東西(它會一直記錄下來),經過 Chat GPT 它會一直處理會回答我們不同的問題(會有不同的輸出)

它的輸出就會在這裡,它的輸出不是全部倒掉

我們一直輸入,我們會繼續問不同的問題,我們一直問的時候

它一直儲存在水管,你當水管是很大,那水管就一直儲存著,然後它就一直處理

根據以前因為一直輸入很多東西,它記錄下來;然後才輸出,輸出不是最後一次

我輸入什麼水它才輸出,是一直以來我輸入很多水(它會去分析然後才輸出)

根據我輸入了多少東西在裡面

解説影片

AI 也有忘記的概念

那就是 forget 的概念

沒錯,當我輸入了很多東西;但其實這些系統是一個 short term memory 它不會永遠記錄所有的東西,所以它會偶爾有一個 forget 的記錄

將你輸入的資訊(這些水會流走),所以意思就是說我和它聊天的時候,我可能輸入了幾篇論文我以為它已經記錄了我所有的東西

其實不是的,原來有一部分的資訊會流走;但最關鍵的問題就是那個部分有多大,只不過那個部分有多大我們是不會知道的

Chat GPT Long Short Term Memory

我們現在用這個 ChatGPT 的時候,我們先看什麼是 long short term memory,我現在一直和它溝通

我在這次和它溝通的時候,你會看到左手邊沒有了 history,如果它沒有了history,就不會像這幅圖它會記住我和它溝通過什麼

如果它記不住我和它溝通過的東西;其實就沒有了一個,好像叫 trained 一個 persona 又好或者一個 profile 又好(你賦予了它一個身份)

現在是沒有了,你看到所以這個就會影響到所謂叫我們自己 trained 一個 model 在網上,現在沒有了

我們 trained 完它之後,它會洩漏了多少(這些內容其實我們也不知道),但我猜為什麼它要在這個時刻你會看到左手邊沒有了 history,你想像我們一直和它溝通的時候,它會在這裏放很多東西(那些水就會越來越多)

然後它經過這麼大量的數據(即是我們的內容)即是水,然後才去分析,其實那個 token 的數量就會大一點,其實它每一次要加多一點東西進去的時候 token 的數量就會大了才可以分析到和 output

簡單來說就是很貴,如果我每次問它一個問題、它每次都清晰的話數目就會有限;但如果我每次回答完問題,在這裏一直回答,其實它需要用到 token 的數量就會很多(成本就會很高)

但它就好像有記憶可以和你去回答,所以我猜這是其中一個原因、所以我們間中會失去history(因為很貴)

POE 作爲例子

因為你記錄很多資訊的時候其實會很貴,另外就是我用 POE 的時候,我問它一個問題

你可以儲存很多資訊,雖然儲存了很多資訊,究竟它會每一次是否在聊天的時候會全部放進去

還是會用 forget 的機制把資訊留在那些資訊,它沒有說

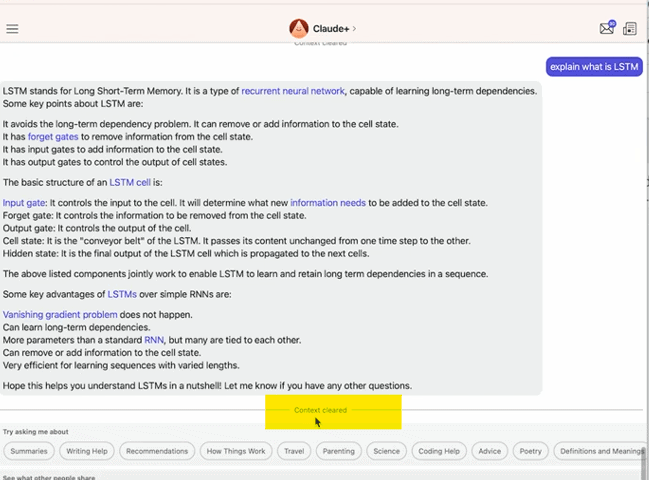

但它下面有一個掃把的按鈕,我按掃把的時候我一路可以和它聊天,它就會記錄下來,它就會說那個 context 是 clear 了

當那個 context 是 clear 了的話代表了一件事等於一直儲存在(那些水一直儲存在,那些水在這個水喉,一次過在 forget 的機制全部流走)

它就沒有了之前的資訊,所以我之後在這個 context clear了之後再打的東西,是一個全新對於它沒有記憶的問題

好處就是它不會需要記住之前我說過的影響之後的答案;壞處就是記憶力如果一直都在問相關的問題,你當然想它記住相關的東西然後回答出來會好一點

兩個方向看待 Long Short Term Memory

所以有兩個不同的方向去看這件事;但現在見比較多就是 chst GPT 經常沒有了 history,不知道會不會就是因為它在那個水喉的排列裏放了很多 input 進去,它每一次用這些input 再去分析出個 output 的時候它的成本就會高了

因為它將之前的東西連帶丟進去 token,這個是我其中的估計